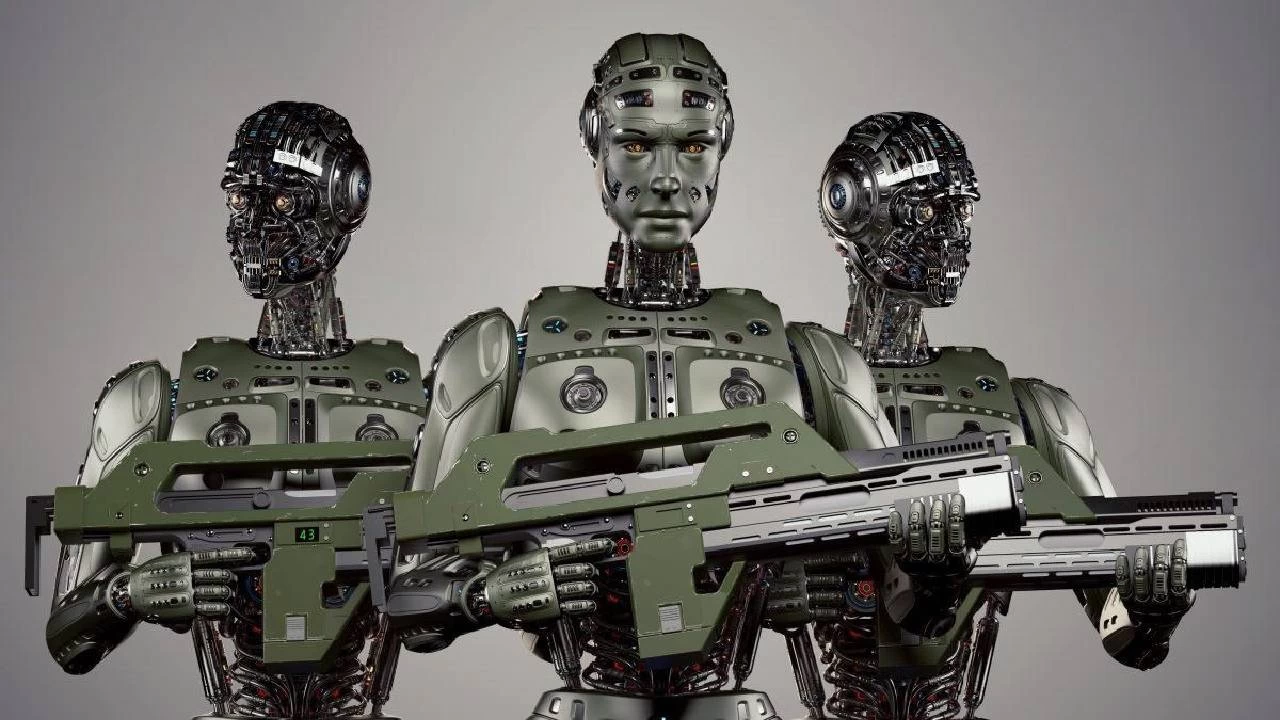

Savaş meydanlarının yeni hakimi yapay zeka mı olacak?

Robotlar savaş meydanının yeni hakimleri mi olacak? Yapay zekanın ölümcül silah sistemlerinde kullanımı, verimlilik ve hız vaat ederken, insanlığın etik ve hukuki sınırlarını zorluyor

27.05.2025 21:30:00 / Güncelleme: 27.05.2025 21:34:02

Eyüp Kabil

Eyüp Kabil

Yapay zeka teknolojilerindeki baş döndürücü gelişmeler, askeri alanda da devrim niteliğinde değişikliklere yol açıyor.

Özellikle "öldürücü otonom silah sistemleri" (LAWS - Lethal Autonomous Weapon Systems) veya daha bilinen adıyla "katil robotlar"ın geliştirilmesi, uluslararası arenada hem büyük bir potansiyel hem de derin etik ve hukuki endişelerle tartışılıyor.

Bu sistemler, bir kez aktive edildiklerinde, insan müdahalesi olmadan hedef seçme ve hedefe saldırma yeteneğine sahip. Peki, bu teknolojik ilerleme, savaşın geleceğini nasıl şekillendirecek ve insanlığın bu konudaki sorumluluğu ne olmalı?

TEKNOLOJİK İLERLEME VE ASKERİ AVANTAJLAR

Yapay zeka destekli silah sistemlerinin savunma sanayisine vaat ettiği başlıca avantajlar arasında operasyonel verimlilik, hız ve risk azaltma yer alıyor. İnsan operatörlerin yorulabileceği veya duygusal kararlar alabileceği durumlarda, otonom sistemler daha hızlı ve rasyonel kararlar alabilir.

Bu sistemler, insan kayıplarını en aza indirerek tehlikeli görevleri üstlenebilir, keşif ve gözetleme faaliyetlerinde daha uzun süre görev yapabilir veya belirli bölgelerdeki tehditleri insan müdahalesine gerek kalmadan etkisiz hale getirebilir. Özellikle "sürü dronlar" gibi otonom sistemlerin koordineli çalışması, yeni nesil savaş stratejilerinin temelini oluşturma potansiyeline sahip.

ETİK VE HUKUKİ İKİLEMLER

Ancak bu teknolojik ilerlemenin beraberinde getirdiği etik ve hukuki ikilemler, uluslararası toplumda ciddi tartışmalara yol açıyor. En temel soru, "bir makine insan hayatına karar verebilir mi?" Savaş hukukunda, savaşan tarafların sivilleri ve sivil altyapıyı koruma yükümlülüğü bulunur.

Otonom sistemlerin, savaşın karmaşık ve dinamik ortamında bu ayrımları ne kadar doğru yapabileceği belirsizdir. Algoritmik önyargılar, yanlış hedeflere saldırı riskini artırabilir ve bu durum, savaş suçları bağlamında kimin sorumlu tutulacağı sorusunu gündeme getirir. Bir yapay zeka sisteminin aldığı hatalı bir karar sonucunda yaşanan sivil kayıplardan üretici mi, programcı mı, yoksa sistemi kullanan askeri personel mi sorumlu olacaktır?

SİLAHLANMA YARIŞI VE İSTİKRARSIZLIK

Otonom silah sistemlerinin geliştirilmesi, yeni bir silahlanma yarışına yol açabilir. Büyük askeri güçler (ABD, Çin, Rusya gibi), bu alandaki üstünlüğü ele geçirmek için yoğun Ar-Ge faaliyetleri yürütüyor. Bu durum, küresel istikrarsızlığı artırma potansiyeline sahip.

Otonom sistemlerin düşük maliyetli olması ve kolayca çoğaltılabilmesi, bu teknolojinin devlet dışı aktörlerin veya terör örgütlerinin eline geçmesi riskini de beraberinde getiriyor. Bu durum, gelecekteki çatışmaların doğasını kökten değiştirebilir ve kontrol dışı bir şiddet sarmalına yol açabilir.

ULUSLARARASI ANLAŞMALARIN GEREKLİLİĞİ

Bu endişeler nedeniyle, Birleşmiş Milletler (BM) çatısı altında otonom silah sistemlerinin geleceği hakkında müzakereler devam ediyor. Bazı ülkeler, bu sistemlerin geliştirilmesini ve kullanılmasını tamamen yasaklayan bağlayıcı bir uluslararası anlaşma çağrısı yaparken, bazıları ise belirli kısıtlamalarla kullanımına izin verilmesi gerektiğini savunuyor. Bu tartışmalar, teknolojinin hızına yetişmeye çalışan hukukun ve etiğin karmaşık dansını gözler önüne seriyor.

Sonuç olarak, yapay zekanın silahlı sistemlerde kullanımı, insanlığın karşı karşıya olduğu en kritik teknolojik ve etik ikilemlerden birini temsil ediyor. Bu sistemlerin potansiyel faydaları göz ardı edilemez olsa da, insan kontrolünün ve sorumluluğunun korunması, savaşın geleceğinin insani değerlerden sapmamasını sağlamak adına hayati öneme sahiptir. Uluslararası toplumun bu konuda acilen ortak bir zemin bulması ve bağlayıcı kurallar geliştirmesi, sadece savaşın doğasını değil, insanlığın kendi geleceğini de şekillendirecektir.

Özellikle "öldürücü otonom silah sistemleri" (LAWS - Lethal Autonomous Weapon Systems) veya daha bilinen adıyla "katil robotlar"ın geliştirilmesi, uluslararası arenada hem büyük bir potansiyel hem de derin etik ve hukuki endişelerle tartışılıyor.

Bu sistemler, bir kez aktive edildiklerinde, insan müdahalesi olmadan hedef seçme ve hedefe saldırma yeteneğine sahip. Peki, bu teknolojik ilerleme, savaşın geleceğini nasıl şekillendirecek ve insanlığın bu konudaki sorumluluğu ne olmalı?

TEKNOLOJİK İLERLEME VE ASKERİ AVANTAJLAR

Yapay zeka destekli silah sistemlerinin savunma sanayisine vaat ettiği başlıca avantajlar arasında operasyonel verimlilik, hız ve risk azaltma yer alıyor. İnsan operatörlerin yorulabileceği veya duygusal kararlar alabileceği durumlarda, otonom sistemler daha hızlı ve rasyonel kararlar alabilir.

Bu sistemler, insan kayıplarını en aza indirerek tehlikeli görevleri üstlenebilir, keşif ve gözetleme faaliyetlerinde daha uzun süre görev yapabilir veya belirli bölgelerdeki tehditleri insan müdahalesine gerek kalmadan etkisiz hale getirebilir. Özellikle "sürü dronlar" gibi otonom sistemlerin koordineli çalışması, yeni nesil savaş stratejilerinin temelini oluşturma potansiyeline sahip.

ETİK VE HUKUKİ İKİLEMLER

Ancak bu teknolojik ilerlemenin beraberinde getirdiği etik ve hukuki ikilemler, uluslararası toplumda ciddi tartışmalara yol açıyor. En temel soru, "bir makine insan hayatına karar verebilir mi?" Savaş hukukunda, savaşan tarafların sivilleri ve sivil altyapıyı koruma yükümlülüğü bulunur.

Otonom sistemlerin, savaşın karmaşık ve dinamik ortamında bu ayrımları ne kadar doğru yapabileceği belirsizdir. Algoritmik önyargılar, yanlış hedeflere saldırı riskini artırabilir ve bu durum, savaş suçları bağlamında kimin sorumlu tutulacağı sorusunu gündeme getirir. Bir yapay zeka sisteminin aldığı hatalı bir karar sonucunda yaşanan sivil kayıplardan üretici mi, programcı mı, yoksa sistemi kullanan askeri personel mi sorumlu olacaktır?

SİLAHLANMA YARIŞI VE İSTİKRARSIZLIK

Otonom silah sistemlerinin geliştirilmesi, yeni bir silahlanma yarışına yol açabilir. Büyük askeri güçler (ABD, Çin, Rusya gibi), bu alandaki üstünlüğü ele geçirmek için yoğun Ar-Ge faaliyetleri yürütüyor. Bu durum, küresel istikrarsızlığı artırma potansiyeline sahip.

Otonom sistemlerin düşük maliyetli olması ve kolayca çoğaltılabilmesi, bu teknolojinin devlet dışı aktörlerin veya terör örgütlerinin eline geçmesi riskini de beraberinde getiriyor. Bu durum, gelecekteki çatışmaların doğasını kökten değiştirebilir ve kontrol dışı bir şiddet sarmalına yol açabilir.

ULUSLARARASI ANLAŞMALARIN GEREKLİLİĞİ

Bu endişeler nedeniyle, Birleşmiş Milletler (BM) çatısı altında otonom silah sistemlerinin geleceği hakkında müzakereler devam ediyor. Bazı ülkeler, bu sistemlerin geliştirilmesini ve kullanılmasını tamamen yasaklayan bağlayıcı bir uluslararası anlaşma çağrısı yaparken, bazıları ise belirli kısıtlamalarla kullanımına izin verilmesi gerektiğini savunuyor. Bu tartışmalar, teknolojinin hızına yetişmeye çalışan hukukun ve etiğin karmaşık dansını gözler önüne seriyor.

Sonuç olarak, yapay zekanın silahlı sistemlerde kullanımı, insanlığın karşı karşıya olduğu en kritik teknolojik ve etik ikilemlerden birini temsil ediyor. Bu sistemlerin potansiyel faydaları göz ardı edilemez olsa da, insan kontrolünün ve sorumluluğunun korunması, savaşın geleceğinin insani değerlerden sapmamasını sağlamak adına hayati öneme sahiptir. Uluslararası toplumun bu konuda acilen ortak bir zemin bulması ve bağlayıcı kurallar geliştirmesi, sadece savaşın doğasını değil, insanlığın kendi geleceğini de şekillendirecektir.

Yorumlar

Yorum bulunmuyor.